Raport: serwery w firmie

REKLAMA

REKLAMA

Różnią się wydajnością, pojemnością podsystemu dyskowego i wieloma innymi elementami, na które trzeba zwrócić uwagę przy wyborze konkretnego rozwiązania.

REKLAMA

REKLAMA

Wyznaczanie celu

Przed podjęciem decyzji o zakupie serwera należy określić zadanie, do jakiego dana maszyna będzie wykorzystywana. Może to być obsługa stron www, serwer pocztowy, serwer udostępniający pliki, serwer z bazami danych, itp. Oprócz usługi, jaką dany serwer będzie realizować, trzeba też wziąć pod uwagę potencjalne jego obciążenie. Inna maszyna będzie potrzebna do obsługi 100 odwiedzin dziennie na firmowej stronie www, a inna, kiedy odwiedzin będzie kilkaset tysięcy.

Kolejną, nie mniej ważną cechą jest oprogramowanie serwera. Tu znowu przed zakupem wybranego rozwiązania konieczna jest wiedza na temat usługi, jaką dany serwer będzie świadczył i za pomocą jakiego oprogramowania. Na przykład, inne wymogi co do pamięci operacyjnej będzie stawiał serwer pracujący pod kontrolą Windows Serwer 2008, a inne pracujący pod kontrolą Centos 5 (dystrybucja systemu Linuks).

REKLAMA

Jeśli potrzebujemy serwera, na którym będzie znajdować się baza danych, do wyboru mamy: MySQL, Oracle, PostgreSQL, Microsoft SQL Server i inne. Tak naprawdę to aplikacja determinuje typ bazy danych, a ta z kolei powinna decydować o tym, jaki serwer zostanie zakupiony. Podobnie rzecz wygląda z innymi usługami. Do serwera plików czy serwera pocztowego można wykorzystać wiele różniących się aplikacji, zarówno płatnych, jak i darmowych.

Reasumując, przed zakupem serwera należy wiedzieć dokładnie, jakie usługi chcemy uruchomić, za pomocą jakiego oprogramowania oraz uwzględnić obecne i prognozowane, przyszłe obciążenie. Chodzi o to, żeby zakup nie był przeinwestowany, a jego możliwości nie będą wykorzystywane, ale też by oszczędzając pewną kwotę, nie kupić maszyny, która nie sprosta zadaniom, nie zapewni odpowiedniej jakości usług.

Większa niezawodność, czyli HA

Jeśli od serwera i uruchomionych na nim usług wymagamy niemalże ciągłej, niezawodnej pracy, mówimy wówczas o tzw. wysokiej dostępności (High Availability).

Cała infrastruktura informatyczna składa się z warstw. Warstwa następna zależy od poprzedniej. Jest to szeregowe połączenie poszczególnych elementów, gdzie w przypadku awarii choć jednego nie działają pozostałe. I tak jest właśnie z serwerami i działającymi na nich usługami. Aby zwiększyć niezawodność, każdy element takiej infrastruktury musi mieć swoją „rezerwę”, która w razie awarii przejmie zadania podstawowego elementu.

Elementy te można podzielić ogólnie na sprzętowe (hardware) i programowe (software).

W praktyce przede wszystkim występuje nadmiarowość zasilania. Serwer wyposażony jest w dwa zasilacze, w przypadku awarii jednego, pracuje na drugim. Drugim elementem zwiększającym niezawodność sprzętu jest stosowanie dysków twardych w tzw. trybie RAID 1 lub RAID 5. Dane zapisywane są na więcej niż jednym dysku. Kiedy dochodzi do awarii jednego, pozostałe mają wszystkie informacje, które znajdowały się na uszkodzonym nośniku.

Następny element to interfejs sieciowy. W razie uszkodzenia jednej karty sieciowej, druga nadal ma połączenie z siecią lokalną i/lub Internetem.

W zasadzie nie stosuje się nadmiarowości procesorów czy pamięci. W praktyce funkcjonuje jednak zasada, żeby w serwerze był zamontowany jeden procesor i jedna kość pamięci więcej, niż wymagają tego zainstalowane usługi. W przypadku awarii procesora czy pamięci elementy uszkodzone są wyłączane, a ich pracę przejmują zapasowe.

Chcąc jeszcze bardziej zwiększyć poziom niezawodności sprzętu, łączy się kilka serwerów (przynajmniej dwa) w klaster. Zastosowanie technologii klastra pozwala na zrównoważenie obciążenia (tzw. Load Balancing) oraz większą niezawodność, i to zarówno sprzętową, jak i programową. Jeśli w klastrze zepsuje się jeden serwer (zwany węzłem klastra), jego zadania przejmuje inny lub przekierowanie następuje na kilka maszyn. Wszystko odbywa się automatycznie, bez przerwy w świadczeniu usługi. Klaster można zbudować, opierając się na systemach operacyjnych Microsoftu, ale i na systemach z rodziny Linuksa. Oczywiście, podwyższona niezawodność kosztuje.

Zwiększenie wykorzystania zasobów, czyli wirtualizacja

Technologia wirtualizacji pozwala utworzyć wiele niezależnych maszyn wirtualnych na jednym fizycznym serwerze. W ten sposób na jednej fizycznej maszynie może być uruchomionych w tym samym czasie nawet kilkadziesiąt różnych systemów operacyjnych z różnymi aplikacjami. Za pomocą specjalizowanego oprogramowania odpowiednio rozdziela się moc obliczeniową procesora, pamięć operacyjną i interfejsy sieciowe. Na stałe można zarezerwować odpowiednią moc obliczeniową lub zarządzać tym dynamicznie. Oprogramowanie do wirtualizacji, w zależności od producenta i oferowanych funkcji, może być bezpłatne lub kosztować od kilkuset do kilku tysięcy dolarów dla najbardziej zaawansowanych rozwiązań, które dają administratorowi serwera cały szereg narzędzi do zarządzania i sterowania wieloma parametrami.

Wirtualizację stosuje się w sytuacji, kiedy chcemy uruchomić wiele usług, ale żadna z nich, pracując pojedynczo na fizycznym serwerze, nie wykorzysta jego mocy obliczeniowej w pełni. Wyobraźmy sobie sytuację, że dana usługa wykorzystuje moc procesora w szczytowym momencie tylko w 5%, to samo tyczy się wykorzystania pamięci operacyjnej i dyskowej. Gdyby tak zostawić, wówczas marnotrawione byłyby możliwości serwera. Wirtualizacja pozwala dołożyć kolejną usługę świadczoną przez inny, niezależny system operacyjny. Jeśli po dołożeniu drugiej usługi nadal mamy rezerwę zasobów, możemy dołożyć kolejną i kolejną, aż do pełnego wykorzystania możliwości sprzętu (pozostawiając pewien margines niewykorzystanej mocy).

Wirtualizacja zwiększa stopień wykorzystania zasobów serwera, upraszcza infrastrukturę serwerową, ułatwia zarządzanie usługami, a także prowadzi do obniżenia wykorzystywanej energii (jeden, choćby najmocniejszy serwer potrzebuje mniej energii niż kilkanaście czy łącznie kilkadziesiąt słabszych). Dzięki zastosowaniu wirtualizacji oszczędzamy też miejsce w samej serwerowni. Nade wszystko jednak wirtualizacja pozwala oszczędzić często bardzo duże pieniądze i choć taka technologia ma także wady, od kilku lat zdobywa coraz większą popularność. Dziś jest szeroko stosowana w wielu dużych przedsiębiorstwach.

Skoro o wadach mowa, warto zaznaczyć, że w momencie awarii sprzętowej lub programowej maszyny, na której są serwery wirtualne, następuje przerwa w świadczeniu usług wszystkich maszyn wirtualnych, jakie były zainstalowane na fizycznym serwerze. Żeby zapobiec takiej sytuacji, należy stosować drugi, fizyczny serwer zapasowy, który w każdej chwili przejmie zadania od serwera głównego.

Wirtualizację stosuje się także do zwiększenia niezawodności świadczonych usług. Informatycy często stosują model, w którym daną usługę świadczy serwer fizyczny, ale w chwili awarii uruchamiana jest jego kopia jako maszyna wirtualna.

Wybór konkretnych rozwiązań

Kiedy określimy usługi, jakie będą świadczone na serwerze, znane będzie jego potencjalne obciążenie, przychodzi kolej na wybór podzespołów. Doświadczony handlowiec lub pracownik IT określa, na podstawie powyższych założeń, z jakich elementów serwer musi się składać. Podstawowe parametry to m.in.: typ procesorów, ich liczba i wydajność, pojemność pamięci operacyjnej, typ płyty głównej, a także typ, liczba i pojemność dysków twardych oraz liczba interfejsów sieciowych, typy kontrolera dysków twardych.

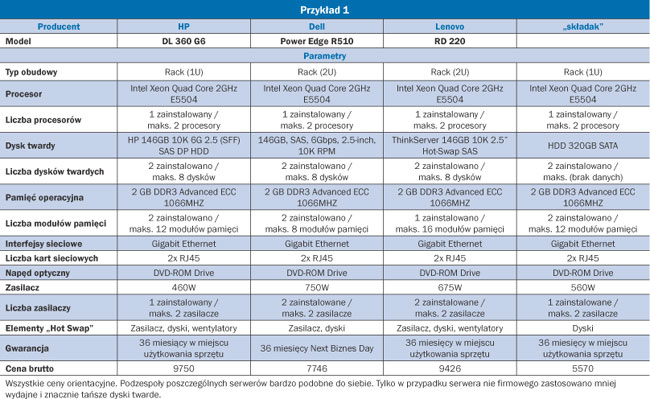

Na poniższych przykładach widać dużą różnicę w cenie pomiędzy konkurencyjnymi rozwiązaniami, szczególnie między serwerami znanych firm a sprzętem wyprodukowanym przez mało znaną firmę. Rozbieżności cenowe mogą być spore, choć pod względem podzespołów i wydajności różnice są niewielkie lub praktycznie żadne. Wynikają z tego, że wielcy producenci, tacy jak Hewlett Packard, Dell czy Lenovo, mają wiele własnych patentów, dotyczących np. eliminacji zakłóceń elektromagnetycznych, systemów chłodzenia, czy też posiadają własne oprogramowanie wspomagające zarządzanie, diagnozowanie i monitorowanie pracy serwera. Dodatkowo czołowi producenci często udzielają, za dodatkową opłatą, dłuższej gwarancji lub/i oferują 24-godzinne wsparcie gwarancyjne w tym czasie. W droższych rozwiązaniach spotyka się nawet systemy, które za pośrednictwem Internetu powiadamiają producenta o awarii, np. dysku twardego. W ten sposób w ciągu kilku godzin poprzez lokalnego partnera producent wymienia uszkodzoną część w siedzibie klienta. Tego nie oferują wytwórcy serwerów z najniższej półki, szczególnie mało znane firmy.

Powodem takiego postępowania jest wolumen sprzedaży. Najwięksi producenci każdy model serwera sprzedają często w setkach tysięcy, milionach sztuk. Przy takiej skali produkcji opłaca się przeprowadzenie wielu testów sprawdzających poprawność działania oraz kompatybilność zamontowanych podzespołów, ponieważ koszt przypadający na jeden serwer będzie niewielki, a ryzyko wymiany całej serii w przypadku stwierdzenia wady konstrukcyjnej pociąga za sobą gigantyczne straty. Tego mali producenci nie są w stanie wykonać. I choć podzespoły użyte do budowy serwera (np. procesor, płyta główna, pamięć) są te same, to niezawodność całego urządzenia może być zdecydowanie mniejsza niż w przypadku markowych rozwiązań. To jednak nie oznacza, że nie należy rozważyć zakupu serwera od mniejszej firmy. Czasami cena jest na tyle atrakcyjna, budowa solidna, a wsparcie producenta wystarczające, że taki wybór może być optymalny.

Czego unikać?

Należy unikać rozwiązań, w których sprzęt tylko udaje serwer, a tak naprawdę jest zwykłym komputerem biurowym typu desktop. Serwer od komputera biurowego wyróżnia możliwość zainstalowania przynajmniej dwóch zasilaczy (może być zainstalowany jeden, ale jest miejsce na dokupienie i montaż drugiego). Należy też unikać serwerów z płytami głównymi, na których można maksymalnie zamontować tylko jeden procesor czy 4 moduły pamięci. Zainstalowane moduły pamięci powinny obsługiwać korekcję błędów, tzw. ECC. Praktycznie minimalną prędkością talerzy obrotowych dysków twardych jest 10 tys. obrotów na minutę. Jeśli mamy do czynienia z ofertą, w której parametry sugerują, że nie są przeznaczone do serwerów, nie wolno ulec pokusie niskiej ceny. Główna różnica między elementami serwerowymi a tymi, które są przeznaczone do komputerów biurowych, to trwałość i niezawodność elementów. Przy droższych rozwiązaniach serwerowe podzespoły (np. dyski twarde, zasilacze i wentylatory) powinny być typu Hot swap, co oznacza, że w przypadku awarii można je wymienić bez wyłączania maszyny.

Rabaty

Producenci serwerów, szczególnie najwięksi, stosują tzw. Price List - to lista cen poszczególnych serwerów, macierzy, podzespołów i innych rozwiązań. Nie stanowi ona tajemnicy handlowej i jest szeroko dostępna. Porównując poszczególne oferty, trzeba pamiętać o rabatach. Może się zdarzyć, że rozwiązanie pierwotnie najdroższe po negocjacjach z dostawcami i otrzymaniu dużego rabatu będzie najtańsze. Rabaty w określonych sytuacjach (promocja, wyprzedaż, itp.) mogą osiągnąć nawet kilkadziesiąt procent ceny wyjściowej.

Przy dużych zakupach warto zawalczyć o korzystne ceny, bo na polskim rynku panuje duża konkurencja wśród dostawców. Można nawet zorganizować przetarg wśród dostawców, mimo że ustawodawca nas do tego nie obliguje. Zakupy serwerów powinno się robić z pewnym wyprzedzeniem czasowym, ponieważ w odróżnieniu do komputerów biurowych na serwery trzeba czekać nawet kilka tygodni, a pośpiech nie jest dobrym argumentem w trakcie negocjacji cen.

Przykład 1

Mała firma spedycyjna. Firma zatrudnia własną kadrę IT. Zakupiony serwer będzie realizował takie usługi, jak:

• hosting firmowej strony www;

• wewnętrzna aplikacja wspomagająca proces logistyczny, oparta na bazie danych Microsoft SQL Server;

• serwer plików dla pracowników i klientów (serwer FTP); całkowita, wymagana powierzchnia dyskowa to 100GB (w trybie RAID 1 potrzebne będą dwa dyski o pojemności co najmniej 100 GB każdy);

• aplikacja do fakturowania i innych rozliczeń z kontrahentami.

Ze względu na przewidywaną małą obciążalność poszczególnych usług realizacja ich będzie się odbywać na jednym serwerze. Dopuszczalna jest dłuższa przerwa w działaniu tych usług, tak więc nie ma potrzeby nadmiarowości serwerów.

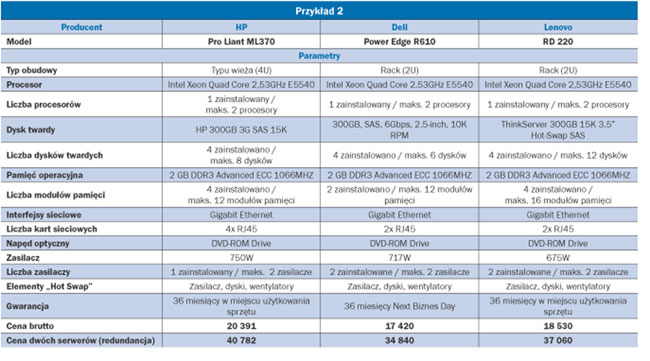

Przykład 2

Firma reklamowa. Istnieje potrzeba zrealizowania usług IT:

• hosting własnej strony www i hosting powierzonych stron od firm trzecich. Usługa jest realizowana poprzez serwer www apache pod kontrolą systemu Linuks;

• serwer plików na potrzeby wewnętrzne realizowany za pomocą serwera Samba pod kontrolą systemu Linuks;

• kontroler domeny zrealizowany za pomocą Windows Serwer 2008 Enterprise;

• serwer DNS i DHCP realizowany za pomocą Windows Serwer 2008 Standard Edition;

• serwer pocztowy na użytek pracowników realizowany za pomocą Windows Exchange 2003;

• serwer bazy danych oparty na darmowym MySQL.

Przewiduje się małą obciążalność poszczególnych usług. Wymagana jest wysoka dostępność, czyli nie jest dopuszczalna dłuższa przerwa w pracy usług. Zakup będzie dotyczył dwóch serwerów, by drugi mógł przejąć zadania serwera głównego w przypadku awarii. Ponieważ poszczególne usługi realizowane są przez różne systemy operacyjne, a także z innych względów, każda usługa musi być realizowana na oddzielnej maszynie wirtualnej.

Całkowita, wymagana powierzchnia dyskowa pozwalająca obsłużyć wszystkie maszyny wirtualne to 500 GB, zainstalowana na samym serwerze (w trybie RAID 1 potrzebne będą cztery dyski o pojemności co najmniej 250 GB każdy).

Dodatkowo wymogiem jest instalacja 8 GB pamięci operacyjnej i jednego procesora czterordzeniowego o minimalnej częstotliwości taktowania 2,53 GHz.

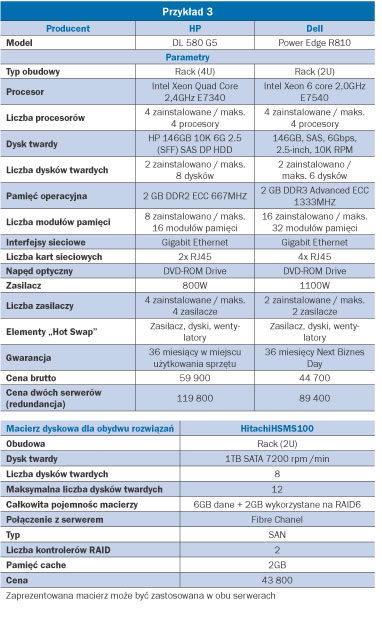

Przykład 3

Duży sklep internetowy. Zakupiony serwer ma obsłużyć aplikację sklepu internetowego pracującego z bazą danych PostgreSQL. Ten sam serwer ma obsługiwać serwer www, za pomocą aplikacji apache. Całość ma pracować na jednym serwerze pod kontrolą Red Hat Linux. Wymagana jest powierzchnia dyskowa o pojemność 6 TB zrealizowana poza serwerem, za pomocą macierzy dyskowej z interfejsem Fibre Chanel w trybie RAID-6 (wymagane dodatkowo dwa dyski twarde).

Zakłada się dużą oglądalność strony (rzędu kilkuset tysięcy odwiedzin dziennie), co pociąga za sobą konieczność zastosowania bardzo wydajnego serwera (duża moc obliczeniowa, dużo pamięci operacyjnej).

Wymagana jest wysoka dostępność, czyli nie jest dopuszczalna dłuższa przerwa w pracy usług. Wymóg ten pociąga za sobą konieczność zakupu drugiego serwera (redundancja sprzętu) i połączenie ich w klaster. Serwery będą pracowały w trybie master-slave, czyli w przypadku awarii jednego, drugi (bez przerwy w świadczeniu usług) przejmie jego zadania.

Robert Drzazgowski

Trzeba słuchać informatyków i księgowego

Adam Czeczuk, wiceprezes INFOR IT

adam.czeczuk @infor.pl

Przed planowanym zakupem serwera warto skonsultować decyzję z pracownikami działu IT, którzy mają doświadczenie we wdrażaniu i użytkowaniu serwerów i są nieocenionym źródłem informacji na temat dostępnych rozwiązań. Z wielkim prawdopodobieństwem można powiedzieć, że informatycy będą proponować zakup wydajnych rozwiązań, z szybkimi procesorami, dużą ilością pamięci, dysków itp. Dlatego warto drugim uchem słuchać, co do powiedzenia ma księgowy. Wszystko po to, żeby spotkać się w połowie drogi, gdzie zakupiony serwer będzie oferował odpowiednie funkcje i wydajność, a przy tym jego cena będzie akceptowalna.

Należy pamiętać, że zakup serwera to dopiero początek drogi, jeśli chodzi o koszty. Do tego dojdą koszty osobowe, zakup dodatkowego wsparcia oraz części zamienne po okresie gwarancyjnym.

Menedżer odpowiedzialny za zakupy sprzętu w firmie powinien dbać, by przy zachowaniu pewnego marginesu bezpieczeństwa zainstalowane serwery były w jak największym stopniu obciążone.

Architektura eX5 mocno obniża koszty i uelastycznia systemy

Mariusz Ziółkowski, System x Sales Unit Manager IBM Polska

Ilość danych przepływających przez systemy przy przeciętnym obciążeniu podwaja się co roku, podnosząc koszty i obciążając zasoby. Użytkownicy zazwyczaj próbowali poradzić sobie ze wzrastającym obciążeniem, wykorzystując jedyną dostępną metodę dla ich platform, jaką jest dodawanie większej liczby serwerów. Zwiększało to zarówno koszty energii, jak i koszty administracyjne. Aby uporać się z przyrostem obciążenia, zaczęto wirtualizować fizyczną infrastrukturę x86, przeciążając pojemność pamięci na serwerach, które były wykorzystywane jedynie w jednej piątej ich możliwości z powodu przestarzałej architektury, która łączy procesor i pamięć. Wykorzystując nową architekturę eX5, użytkownicy otrzymują elastyczne, wysoko skalowalne systemy, które mogą zredukować o połowę zapotrzebowanie na serwery, obniżyć koszty przechowywania danych o 97% i wysokość opłat licencyjnych o połowę.

Mówiąc językiem biznesu: dzięki nowej architekturze eX5 serwery są dziś bardziej elastyczne, ale przede wszystkim możemy umieścić w maszynach dotychczasowych rozmiarów 6 razy więcej pamięci. Większa pamięć do dyspozycji aplikacji i systemów ma w obecnych czasach szczególne znaczenie. To właśnie dostępność pamięci w serwerach, a nie moc obliczeniowa, staje się z reguły wąskim gardłem przy rozbudowie systemów. Obecnie najczęściej napotykamy problem braku możliwości rozbudowy maszyn to dodatkowa pamięć, podczas gdy skalowalność mocy obliczeniowej na ogół nie stanowi problemu.

Właśnie ta nowa cecha - dużo większa skalowalność - jest głównym wyróżnikiem nowej architektury eX5. Uzyskaliśmy ją dzięki architektonicznemu rozdzieleniu procesorów od pamięci, po raz pierwszy w historii przenosząc pamięć z jej tradycyjnego, ściśle określonego miejsca tuż obok procesora w serwerze w inną lokalizację. Ten zabieg pozwala na poszerzanie zasobów pamięci bez konieczności kupna kolejnego urządzenia, a to przekłada się na osiągnięcie znacznych oszczędności kosztowych.

Korzyści z tak istotnej poprawy skalowalności odczują szczególnie te firmy, które decydują się na wirtualizację i centralizację zasobów IT. Wirtualizacja zasobów pozwala umiejscowić na jednej fizycznej maszynie wiele aplikacji i wiele systemów. Oprogramowanie to korzysta ze wspólnej puli zasobów sprzętowych, czyli w głównej mierze właśnie procesorów i pamięci. Jest to o tyle istotne, że wg powszechnie znanych statystyk w tradycyjnej architekturze „jeden serwer - jedna aplikacja” średnio wykorzystywanych jest zaledwie ok. 20% mocy maszyn. Po zwirtualizowaniu możemy korzystać normalnie nawet z 50% możliwości obliczeniowych maszyn, pozostawiając wciąż spory margines na godziny szczytu, kiedy poszczególne systemy mogą potrzebować wyższej wydajności.

Obecnie przyjmuje się, że obciążenie serwerów w biznesie internetowym podwaja się z każdym rokiem. IBM daje gotową odpowiedź w postaci wysoko skalowalnej

REKLAMA

REKLAMA